deepseek本地部署的意思就是将DeepSeek大语言模型直接部署在自己的个人设备或私有服务器上,这样使用起来就不会出现用户繁忙的情况了,但是很多小伙伴不清楚怎么训练使用,下面就和小编一起来看看吧。

本地部署首先要安装ollama,你可以把它理解为,一个装Al的盒子,把Al装在盒子里,方便管理。

1.首先在浏览器搜索ollama,会出现ollama官网,点击进入。

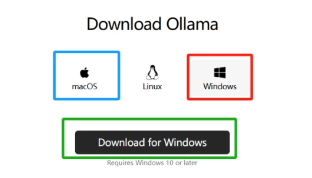

2.进入官网后,点击中间的Download。

3.根据自己的电脑类型,选择不同版本。

苹果电脑选最左边 (蓝色框),Windows系统选最右边(红色框),之后点击下载(绿色框)

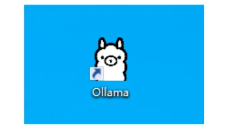

4.下载后,点击安装。

如果桌面出现了ollama图标,说明软件安装成功。图标就是下图的羊驼。

特别说明:最好安装在C盘,安装在其它盘,需要重新配置环境变量

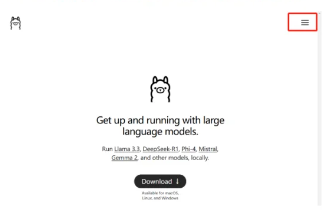

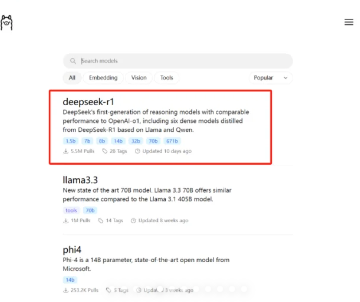

5.还是在刚刚的ollama官网,点击右上角红框的位置。

6.在弹出的界面,点击红框的 “Models”选项

7.点击选择deepseek-r1

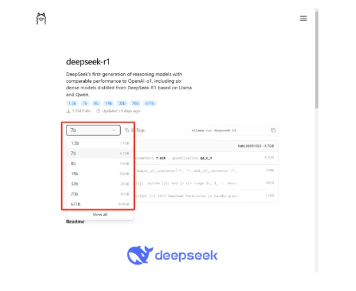

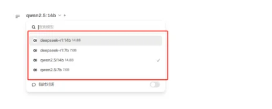

8.选择不同参数的模型

这里的数字越大,参数越多,性能越强,1.5b代表模型具备15亿参数。我的电脑16G显存,运行14b参数模型时,需要大约11.5G显存。如果是1.5b版本,2G以下的显存就可以运行,甚至不需要独立显卡,核显就可以。如果是32b参数的,就需要32G显存啦,可以根据自己的电脑性能选择。

下面选择1.5b参数做示范。

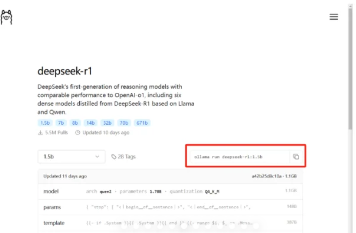

9.复制命令

选择1.5b参数后,复制红框中的命令“ollamarun deepseekr1:1.5b”

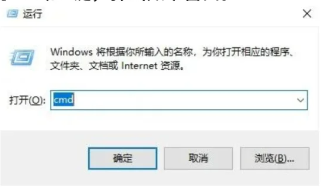

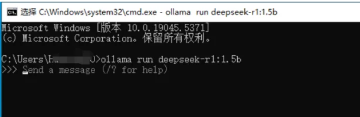

10.打开命令行

同时按下键盘上的Win和R键,弹出如下窗口。

在弹出的窗口中,输入cmd,击确定,打开命令行,就像下面这样。

11.输入下载命令

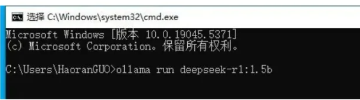

在打开的命令行里,输入上面复制的命令 “ollama run deepseek-

r1:1.5b"

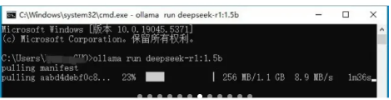

点击键盘上的 “Enter”键,模型会自动下载

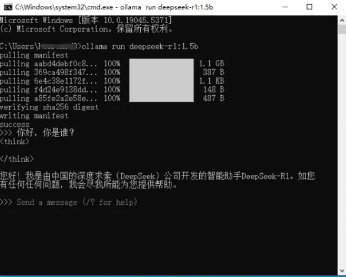

12.与模型对话

下载成功后,就可以与模型对话啦。

在弹出的窗口中,输入cmd,点击确定,打开命令行,就像下面这样。

这里还有一个问题,当你关闭电脑后,下次再打开ollama。会发现点击ollama的图标,电脑没反应。因为你点击图标,只是启动了ollama,想要和大模型聊天,还是需要打开命令行。

13.继续通过命令行和大模型聊天

同时按下键盘上的Win和R键,在弹出的窗口里输入cmd,点击确定打开命令行。在命令行界面,输入刚刚的命令“ollamarundeepseek-r1:1.5b”。因为你之前已经下载过,这次无需下载,可以直接和模型聊天。

注意:前面的步骤,已经完整了。Open-WebUI只是让交互界面更好看,可以不必安装。且建议不熟悉电脑的朋友,先不要安装Open-WebUl。Open-WebUi有比较多的依赖项,安装过程中容易出问题。如果安装半天没完成,容易打击到学习AI的热情,这也是为什么我做的视频里,没有讲

Open-Webui安装步骤的原因

如果执意要安装,则安装步骤如下:

14.首先安装docker

可以用docker来管理操作系统界面,比直接安装Open-WebUl更方便。在浏览器输入docker并搜索,点击进入官网。

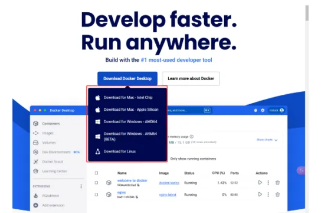

15.根据你的电脑系统,下载docker桌面版,并安装运行。

安装完成后,需要重新启动电脑,才能正常使用docker。重新启动后,如果你的桌面上出现了docker的图标,就表示安装成功了。

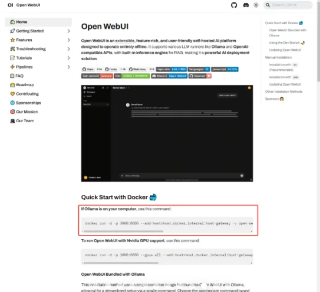

16.安装Open-WebUI

浏览器搜索Open-WebUl,进入官网,并复制红框中的命令。

按照上面提到的步骤,打开命令行,输入复制的命令,等待安装完成。

17.运行Open-WebUI

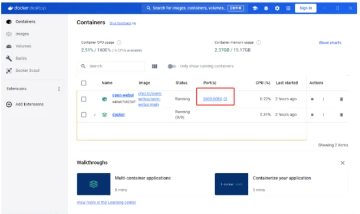

双击docker的桌面图标,打开软件。点击红框端口,即可运行Open-WebUI。

初次访问时,需要注册一个账号。这些信息会储存在你的电脑里。

18.开始对话

在界面左上角,选择你的模型,就可以开始对话啦。

Open-WebUi这部分的安装过程比较简略,如果出现报错,需要具备通过浏览器搜索问题原因,并修复的能力。确实不建议,不熟悉电脑的新手尝试。

e621福瑞控中文版下载(The Wolfs Stash)vbeta-4.12.1 安卓版

e621福瑞控中文版下载(The Wolfs Stash)vbeta-4.12.1 安卓版 系统工具 / 9.9M

系统工具 / 9.9M 慢脚文化软件app官方下载(快手)v13.11.30.45815 官方正版

慢脚文化软件app官方下载(快手)v13.11.30.45815 官方正版 影音视听 / 153.5M

影音视听 / 153.5M 梦狱之国的爱丽丝手机版下载(夢獄の国的爱丽丝)v1.0.0 安卓版

梦狱之国的爱丽丝手机版下载(夢獄の国的爱丽丝)v1.0.0 安卓版 冒险解谜 / 267.1M

冒险解谜 / 267.1M 电鸽app免费下载正版v1.3.5 中文版

电鸽app免费下载正版v1.3.5 中文版 聊天社交 / 135.2M

聊天社交 / 135.2M JMComic21.7.9最新版安装包下载v1.8.2 官方版

JMComic21.7.9最新版安装包下载v1.8.2 官方版 图书阅读 / 36.7M

图书阅读 / 36.7M 异常咖啡机汉化版下载(Anomalous Coffee Machine)v4.2.5 手机版

异常咖啡机汉化版下载(Anomalous Coffee Machine)v4.2.5 手机版 角色扮演 / 650.0M

角色扮演 / 650.0M